Geld sparen mit lokalen llm modellen

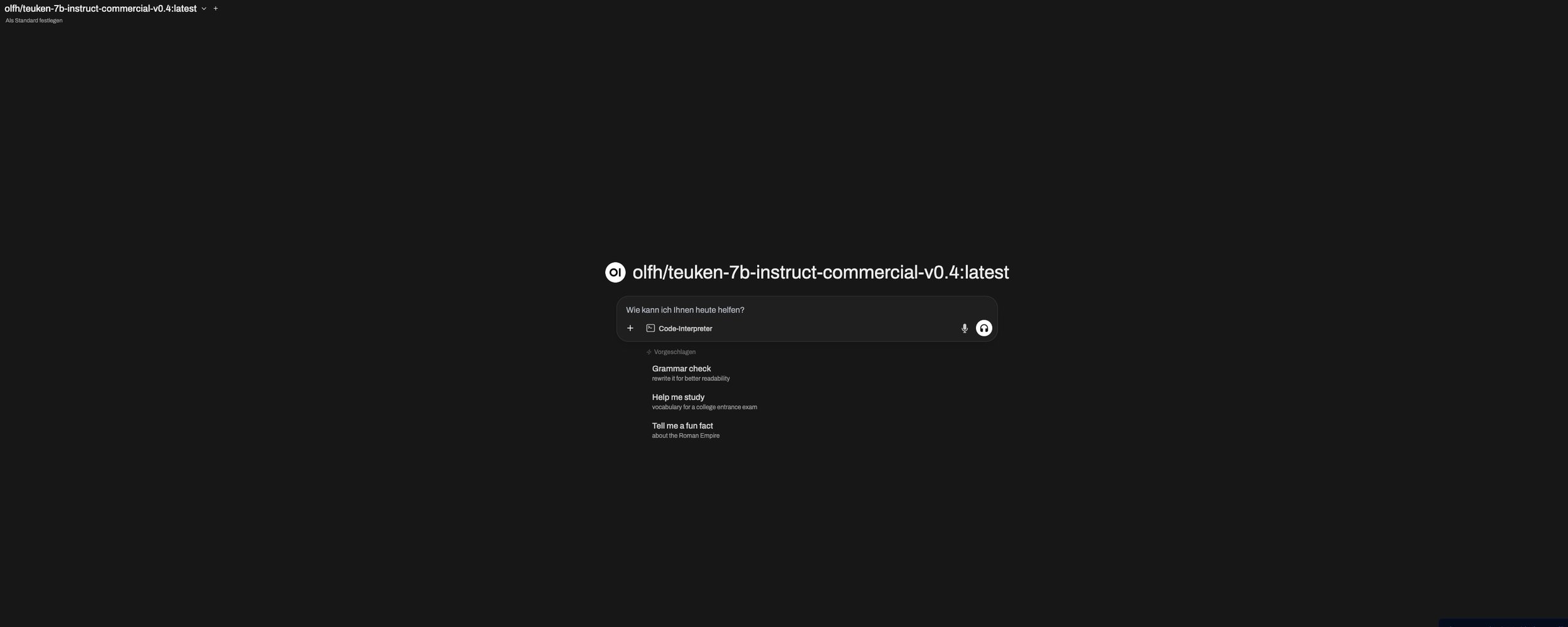

Das ist die Ansicht, die man bekommt, wenn man einen neuen Chat mit der Open WebUI startet.

💡Geld Sparen mit lokalen LLMS

Large Language Models (LLMs) sind einfach fantastisch! Ob privat oder beruflich, sie sind aus meinem Alltag nicht mehr wegzudenken. Doch die vielen Abonnements für verschiedene Modelle können ganz schön ins Geld gehen. Deshalb habe ich mich auf die Suche nach einer kostengünstigen Alternative gemacht und mich mit der Ausführung von LLMs auf meinem lokalen Rechner beschäftigt. Mein Ziel war es, mit minimalem Aufwand eine GPT-ähnliche Umgebung einzurichten. Spoiler: Ich konnte zwar keines meiner Abos komplett ersetzen, aber lokale Modelle haben definitiv Potenzial, die Abhängigkeit von externen Diensten zu reduzieren!

🛠️ Ollama: Die Umgebung für lokale Modelle

Als Umgebung für meine lokalen Modelle habe ich Ollama gewählt. Ollama ist ein Open-Source-Projekt, das die Ausführung von Large Language Models ermöglicht. Die Installation ist mittlerweile kinderleicht, und Ollama ist sogar als Desktop-Anwendung verfügbar. Hier sind die Schritte, die ich zur Einrichtung unternommen habe:

Installation von Ollama:

Lade die neueste Version von Ollama von der offiziellen Website herunter.

Folge den Installationsanweisungen für dein Betriebssystem (Windows, macOS oder Linux).

Modelle verwalten:

Öffne ein Terminal oder die Eingabeaufforderung.

Mit dem Befehl

ollama run <modellname>kannst du ein Modell starten.Um ein Modell herunterzuladenen, nutze

ollama pull <modellname>.Zum Löschen eines Modells verwendest du

ollama rm <modellname>.

Ollama bietet die Möglichkeit, mehrere Modelle gleichzeitig auszuführen und stellt eine Implementierung der OpenAI-API bereit. Das bedeutet, du kannst deine lokalen Modelle genauso ansprechen wie die GPT-Modelle von OpenAI.

Ein weiterer Vorteil von Ollama ist der integrierte Marktplatz für Modelle. Hier kann jeder seine eigenen, angepassten Modelle bereitstellen. Das erleichtert die Nutzung enorm, birgt aber auch Risiken hinsichtlich Lizenzen und Funktionen. Sei also vorsichtig und prüfe die Modelle, bevor du sie einsetzt.

🌐 OpenWebUI: Das Frontend für eine einfache Nutzung

Als Frontend habe ich mich für OpenWebUI entschieden. Es ist benutzerfreundlich und bietet eine Oberfläche, die stark an ChatGPT erinnert. Hier ist, wie du es einrichtest:

Installation von Docker:

Lade Docker Desktop von der offiziellen Docker-Website herunter und installiere es.

OpenWebUI starten:

Lade das OpenWebUI-Docker-Image herunter. (docker pull ghcr.io/open-webui/open-webui:main)

Starte den Docker-Container mit dem Befehl docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

Verbindung mit Ollama:

Folge den Anweisungen auf der OpenWebUI-Seite, um die Verbindung zu Ollama herzustellen.

Sobald die Verbindung steht, kannst du sofort loschatten!

🤖 Mein Lieblingsmodell: Llama3.2

Das Modell, das ich derzeit am häufigsten nutze, ist Llama3.2. Auf meinem M2 Pro-Chip mit 16 GB RAM muss ich allerdings ein stark quantisiertes Modell verwenden, um performante Antworten zu erhalten. Die Quantisierung reduziert zwar die Qualität der Antworten etwas, aber das Modell liefert dennoch beeindruckende Ergebnisse. Ich nutze derzeit ein Q4KM-Modell, das einen guten Kompromiss zwischen Performance und Qualität bietet.

💸 Fazit: Geld sparen mit lokalen Modellen

Lokale Modelle sind eine großartige Möglichkeit, Kosten zu sparen und gleichzeitig die Kontrolle über deine Daten zu behalten. Mit Ollama und OpenWebUI hast du leistungsstarke Tools an der Hand, um deine eigenen LLMs zu betreiben. Probiere es aus und entdecke das Potenzial der lokalen KI-Nutzung!